De meeste mensen denken dat ze nog nauwelijks met kunstmatige intelligentie te maken krijgen: de waarheid is anders. AI is overal. Ook bij de overheid. Hoe kunnen we kunstmatige intelligentie demystificeren en transparant inzetten? Hoe houden we grip op algoritmes? Een verslag van de iBestuur-bijeenkomst 'Computer says no!' "Op de een of andere manier moeten we de kwaliteit van de data verbeteren."

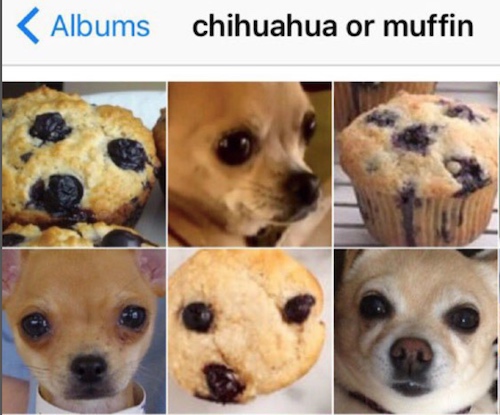

Consumenten denken dat zij nog niet of nauwelijks te maken hebben met AI-technologie, maar de praktijk wijst anders uit. Denk bijvoorbeeld aan face recognition.

Op maandag 17 september vond in Den Haag de rondetafeldiscussie ‘Computer says no!’ plaats, georganiseerd door iBestuur en Pegasystems. Met Marcel Thaens, cio bij de provincie Noord-Brabant als moderator, spraken deelnemers uit overheid, wetenschap en bedrijfsleven uitgebreid met elkaar over het thema kunstmatige intelligentie (AI) en de inzet daarvan bij de overheid.

Wat duidelijk werd tijdens de bijeenkomst is dat artificiële intelligentie een relatief nieuw begrip lijkt, maar niet is, en dat het niet meer weg te denken is uit het dagelijks leven. Facebook, Amazon, Tesla, Netflix, Spotify. Stuk voor stuk voorbeelden die gebruikmaken van AI. Maar dat AI doorgedrongen is tot onze huis- en werkkamers, wil niet zeggen dat AI gesneden koek is. Met name over wat we wíllen met AI (de ethische kant), moet nog een breed debat gevoerd worden.

Een van de mensen in dat debat is Jaap van den Herik, hoogleraar Informatica en Recht aan de Universiteit Leiden en een autoriteit op het gebied van AI. Van den Herik zou graag een debat zien tussen hen die socially driven actief zijn, bijvoorbeeld juristen, en zij die technology driven bezig zijn, bijvoorbeeld data scientists. “Wat mij betreft zijn een multidisciplinaire samenwerking en dito samenleving daarbij het uitgangspunt.” Uitgebreid ging Van den Herik in op wat AI voor de juridische wereld en de rechtspraak kan betekenen. Dat deed hij onder meer aan de hand van een Go-duel tussen de supercomputers AlphaGo en AlphaGo Zero. Waar AlphaGo zijn input haalde uit 40 miljoen grootmeesterpartijen, daar was AlphaGo Zero geheel zelflerend, deep learning. AlphaGo Zero won het onderlinge duel overtuigend: 100 – 0.

Het idee: Alpha Go werd gevoed met menselijke onvolkomenheden: grootmeesterpartijen weliswaar, maar toch niet perfect. Een AI-programma dat zelf leert van scratch en niet gevoed wordt met menselijke imperfecties of vooroordelen, wint.

“Vertaal dat naar de juridische wereld, naar digitale rechtspraak die wordt gevoed wordt met rechtzaken en uitspraken. Zelfs al komen die van de knapste rechters en de knapste juristen van de wereld, dan nog betekent dat dat wij hier beslissingsmechanismen krijgen die eigenlijk niet goed geschikt zijn om recht te spreken. Dat hebben we eigenlijk nooit in de gaten gehad. Het betekent ook dat wij ons opnieuw moeten oriënteren op wat het recht eigenlijk is en wat de concepten zelf betekenen.”

“Er zijn drie uitdagingen als het gaat om AI, algoritmes en ethiek”, aldus Van den Herik. “Het wegnemen van vooroordelen van algoritmes (zoals het gebruik van mannelijke concepten of het toentertijd ‘vanzelfsprekende’ aannamebeleid waarbij mannen de voorkeur kregen boven vrouwen), het creëren van een wiskundige formulering van eerlijke besluitvormingsmetrieken en het ontwikkelen van een nieuwe discipline: Recht, AI en governance.

Van den Herik nam ook een sprong in de toekomst en deed dat naar aanleiding van de uitkomst op een vraag uit de door iBestuur opgestelde enquête over ethiek en technologie. De vraag ‘accepteer je meer camera’s en sensoren in de openbare ruimte die tot doel hebben om jouw gedrag te beïnvloeden?’ werd door ruim tweederde van de respondenten beantwoord met een ‘nee’. Van den Herik deed de voorspelling dat dat percentage in de toekomst flink zal verschuiven. “Ook al bent u op dit moment nog een verstokt ‘nee’-zegger, langzamerhand zult u toch in het het ‘ja’-kamp worden getrokken.” Nog een andere opmerking van Van den Herik was opzienbarend. Hij is ervan overtuigd dat tussen 2080 en 2100 computers betere ethische beslissingen maken dan mensen…

Normen

Ook Marlies van Eck, tot voor kort werkzaam bij de Belastingdienst en nu zelfstandig adviseur AI en recht – en gepromoveerd op geautomiseerde ketenbesluiten en rechtsbescherming – ging in op de betekenis van AI en data voor de juridische wereld. Zij benoemde een viertal normen uit de analoge wereld die ook van betekenis kunnen zijn voor de digitale wereld: het beginsel fair play, het zorgvuldigheidsbeginsel, het verdedigingsbeginsel en het gelijkheidsbeginsel/verbod van discriminatie.

Daarmee gaat het opvallend vaak mis bij het gebruik van de basisregistraties. “We zijn echt helemaal doorgeschoten met die basisregistraties. Het kan misschien handig zijn om informatietechnisch al die registraties aan elkaar te knopen, maar als jurist wil ik weten bij welke rechter ik terechtkan als er iets niet klopt aan een van die registraties. Als burger is het vrijwel onmogelijk om dat uit te zoeken en dat is al ernstig genoeg.”

Van Eck was vrij duidelijk over de positie van de overheid ten opzichte van AI. Zij vindt dat de overheid daar nog lang niet klaar voor is. “Eerst de rechtsbescherming op orde, dan pas verder!”, zo klonk haar waarschuwing.

Remco Boersma, projectleider Big Data Living Lab bij het ministerie van Justitie en Veiligheid, schetste in zijn presentatie de balans tussen kansen en risico’s van AI. “Ik merk dat het in discussies meestal gaat over de risico’s. Dat is misschien ook wel begrijpelijk, want met kansen gaat het vaak over de mogelijkheden en in de meeste gevallen is dat niet zo interessant. Net zo min het voor kranten niet echt interessant is om alleen maar goed nieuws te publiceren.”

Wat betreft Boersma zijn er twee essentiële vragen: Waar zet je AI voor in en hoe doe je dat? Die aspecten kwamen ook terug naar aanleiding van een overleg in de Tweede Kamer, waarbij de wens werd geuit om alle algoritmes binnen de overheid transparant te maken, inclusief de bijbehorende datasets. Die wens leidde ertoe dat op het departement een inventarisatie is gemaakt over de verschillende soorten algoritmes en hun mate van transparantie. “Dat gaat van lage complexiteit bij een eenvoudige beslisboom, bijvoorbeeld voor de afhandeling van verkeersboetes, via rule based systemen bij bijvoorbeeld de risicotaxatie bij verblijfsaanvragen tot aan complexere algoritmes en deep learning systemen voor gezichts- en beeldherkenning.” Hoe begrijpelijker, of transparanter, een algoritme is, hoe groter de impact van het algoritme in het proces. Deep learning systemen worden alleen ondersteunend ingezet. De afhandeling van verkeersboetes gebeurt zonder menselijke tussenkomst.

Boersma kon zich vinden in een reactie van een van de aanwezigen die stelde dat de problematiek van transparantie eigenlijk veel groter is dan alleen de Nederlandse overheid. “Op het moment je AI transparant wilt maken, dan krijgt de Nederlandse wetgever dat alleen niet alleen voor elkaar. Dan zou je je dus sterk moeten maken voor internationale samenwerking: ‘hoe bouw je de techniek en wat moeten eventueel de technische normen worden’. En dat gaat verder dan alleen onze wet- en regelgeving.”

‘Kop in het zand’

Ook Peter van der Putten, global director Decisioning Solutions bij Pegasystems, ging in zijn bijdrage in op kansen en risico’s van AI. Hij vindt dat beide ‘stromingen’ als het ware de kop in het zand steken en grotendeels voorbijgaan aan de vraag wat we eigenlijk willen met AI. “Dáár moet de discussie over gaan. Hoe willen we dat AI-technologie nu en in de toekomst ingezet wordt?” Van der Putten vindt dat de door hem gewenste discussie nog niet voldoende wordt gevoerd. “Dat heeft vooral te maken dat AI gezien (nog steeds) gezien wordt als een hype. Er wordt veel zin en onzin verkocht over AI. Wat mij betreft mag het allemaal meer down to earth komen.”

Uitgebreid ging Van der Putten in op de resultaten van wereldwijd onderzoek dat recent door Pegasystems is uitgevoerd over hoe consumenten denken over AI. “Consumenten denken dat zij nog niet of nauwelijks te maken hebben met AI-technologie, maar de praktijk wijst anders uit. Spamfilters, virtuele assistenten, zoekresultaten op Google, aanbevolen nieuwsitems op Facebook: we gebruiken AI al uitgebreid. Het wordt dan ook tijd dat we AI meer demystificeren.”

Van der Putten vindt het niet echt nuttig om het alleen maar te hebben over de toekomst van AI, over hoe robots de wereld overnemen, maar wil het vooral hebben over wat er vandaag de dag gaande is en wat we nu al kunnen doen. “Dat betekent onder meer kijken welke principes willen we invoeren, maar ook hoe we AI en robotisering kunnen inzetten voor bedrijfsmodellen, maar ook kijken naar voorspellingen die worden gedaan. Waar komen die voorspellingen vandaan?”

Regels, wetten, normen. Kansen versus risico’s. Maar hoe ligt het met de achterliggende waardenstelsel? Marlies van Eck vroeg zich af of wij de waardes al niet aan het kwijtraken zijn? “Moeten we die ook niet aan AI meegeven, zodat het tot betere besluiten kan komen?” Wat haar betreft wordt daar eenzelfde ‘methode’ gehanteerd als bij privacy by design. Dat wil zeggen dat je waardes aan je systeem meegeeft. In Denemarken wordt dat gehanteerd. Daar moet elk IT-systeem van te voren aantoonbaar voldoen aan de regels van het bestuursrecht. Dan gaat het om normen van verdediging, evenredigheid, het zorgvuldig handelen. Al die normen moeten in het systeem ingebakken zijn.”

Afsluitend kwam Jaap van den Herik met een heldere boodschap: “Het gaat niet zozeer om de algoritmes, of de transparantie daarvan, maar om de kwaliteit van de data. Dát is de essentie. Op de een of andere manier moeten we de kwaliteit van de data verbeteren. Over het algemeen weten wij redelijk goed wat die algoritmes doen, maar wij kunnen niet bevatten wat de uitkomst is. Die uitkomst is de data waar wij mee verder gaan. Dáár moeten wij ons om bekommeren.”