De Europese AI Act (of AI-verordening) helpt organisaties om AI veilig, transparant en ethisch te gebruiken. Sinds 1 augustus 2024 is deze wet van kracht en wordt gefaseerd ingevoerd. In dit artikel geven we een stappenplan voor fase 3 van de AI Act.

De mogelijkheden van kunstmatige intelligentie (AI) zijn enorm, maar roepen ook belangrijke vragen op over veiligheid, ethiek en privacy. Daarom is de AI Act in het leven geroepen. Sinds 1 augustus 2024 is deze wet van kracht. Omdat het voor bedrijven en ontwikkelaars vrijwel onmogelijk is om in één keer aan alle regels te voldoen, zijn er fasen opgesteld.

Nu de tweede deadline is gepasseerd, verschuift de focus naar de volgende mijlpaal: Fase 3 op 1 augustus 2025. In deze fase draait het om transparantie bij AI-systemen met beperkt risico.

In dit artikel duiken we dieper in de betekenis van ‘beperkt risico AI’. We leggen uit welke specifieke verplichtingen rondom transparantie de AI Act oplegt. En we vertellen wat de naderende deadline betekent voor organisaties die deze systemen gebruiken.

Maar eerst even samengevat, wat is de AI Act en welke fasen zijn er?

De AI Act: tijdlijn en fasen

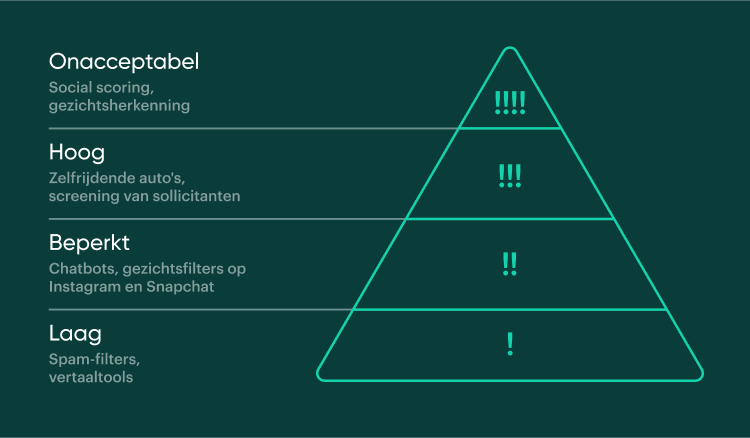

De AI Act is een Europese wetgeving met een risicogebaseerde benadering, waarbij AI-systemen worden ingedeeld op basis van het risico dat ze vormen voor burgers. De risico’s variëren van laag tot onacceptabel.

Risicocategorieën van de AI Act.

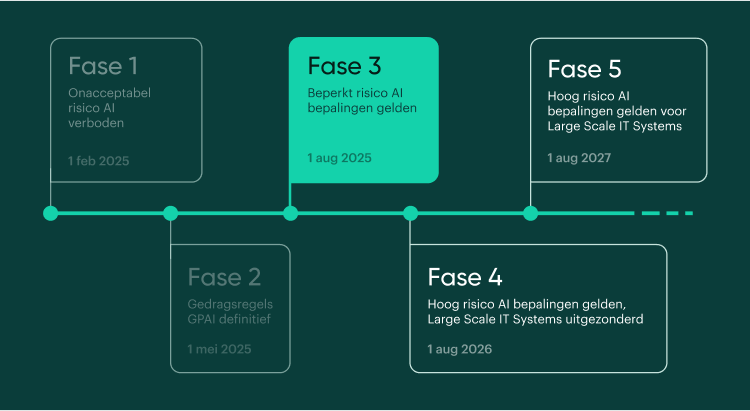

De AI Act wordt stap voor stap ingevoerd. Hieronder zie je wanneer welke fase in gaat:

Tijdlijn AI Act, Fase 3 gaat 1 augustus 2025 van kracht.

De eerste fase van de AI Act draait om het uitfaseren van onacceptabele AI. Zoals social scoring of gezichtsherkenning.

De tweede fase draait om het opstellen van juiste gedragsregels rondom het gebruik van General Purpose AI (GPAI). Denk aan taalmodellen en beeldgeneratie, zoals ChatGPT of Google Gemini.

In de derde fase moet je voldoen aan de regels voor AI-systemen met een beperkt risico. Hierover vertellen we meer in deze blog.

Wat zijn AI-systemen met beperkt risico?

AI-systemen met beperkt risico zijn AI-toepassingen die gebruikers kunnen misleiden of manipuleren. Bijvoorbeeld wanneer gebruikers niet weten dat ze met een chatbot praten in plaats van met een echt persoon. Hier moeten organisaties transparant over zijn.

De AI Act onderscheidt verschillende categorieën binnen beperkt risico AI: interactie-AI, content-genererende AI, biometrische categorisering en deepfakes en manipulatie.

1. Interactie-AI (chatbots en virtuele assistenten)

AI-systemen die direct communiceren met mensen, zoals chatbots op websites of virtuele assistenten in apps.

Risico:

Gebruikers denken dat ze met een echt persoon praten, terwijl ze met AI communiceren.

Voorbeelden:

– Klantenservice chatbots op overheidswebsites

– Virtuele assistenten voor het aanvragen van vergunningen

– AI-gestuurde telefonische helpdesks

2. Content-genererende AI

AI-systemen die tekst, afbeeldingen, audio of video produceren die lijken op door mensen gemaakte content.

Risico:

Gebruikers kunnen niet onderscheiden of content echt of AI-gegenereerd is, wat kan leiden tot misinformatie.

Voorbeelden:

– AI-gegenereerde nieuwsbrieven of rapporten

– Automatisch gegenereerde afbeeldingen voor communicatie-uitingen

– AI-geschreven beleidsteksten of persberichten

3. Biometrische categorisering

AI-systemen die mensen categoriseren op basis van hun biometrische kenmerken.

Risico:

Onbewuste discriminatie en inbreuk op privacy en fundamentele rechten.

Voorbeelden:

– Gezichtsherkenning voor toegangscontrole

– Emotieherkenning in publieke ruimtes

– Leeftijdsschatting via camera’s

4. Deepfakes en manipulatie

AI-systemen die bestaande afbeeldingen, audio of video’s manipuleren waardoor de mensen op die video’s dingen doen of zeggen die ze nooit hebben gedaan.

Risico:

Verspreiding van nepnieuws, reputatieschade en ondermijning van vertrouwen in echte media.

Voorbeelden:

– Gefabriceerde video’s van politici of ambtenaren

– Nep-audio van belangrijke personen

– Gemanipuleerde foto’s voor misleidende campagnes

Hoe voldoe je aan Fase 3 van de AI Act?

Je wilt als organisatie innoveren met AI-toepassingen. Tegelijkertijd wil je voldoen aan de AI Act en risico’s minimaliseren. Voldoe vóór 1 augustus 2025 aan de regels voor beperkt risico AI, anders riskeer je een boete van maximaal 35 miljoen euro of 7% van de jaaromzet, afhankelijk van de ernst van de overtreding en de grootte van de organisatie.

Het volgende stappenplan helpt je te voldoen aan fase 3 van de AI Act en transparant te zijn over het gebruik van AI.

Stappenplan voor transparantie bij beperkt risico AI-systemen

- Kijk welk type AI je gebruikt

Bepaal of jouw AI-systeem valt onder ‘beperkt risico’ volgens de AI Act. Dit zijn bijvoorbeeld systemen die beelden of teksten maken of veranderen, zoals deepfakes. - Maak een duidelijke verklaring

Schrijf een begrijpelijke tekst waarin je uitlegt dat mensen met een AI-systeem te maken hebben. Leg uit wat het AI-systeem doet en waarvoor het bedoeld is. - Deel de informatie met je gebruikers

Zorg dat gebruikers van jouw site of app de informatie goed kunnen zien, voordat ze het AI-systeem gaan gebruiken. Gebruik duidelijke taal, die past bij je doelgroep. - Zorg voor technische oplossingen

Bouw functies in je AI-systeem die gebruikers waarschuwen wanneer ze inhoud zien die met AI is gemaakt. Gebruik watermerken of andere tekens om dit duidelijk te maken. - Leid je medewerkers op

Zorg dat iedereen die met het systeem werkt weet wat de regels zijn voor transparantie en hoe ze die moeten toepassen. - Blijf controleren en verbeteren

Houd bij of je transparantiemaatregelen goed werkenen vraag gebruikers wat zij ervan vinden. Pas je aanpak aan op basis van deze feedback en nieuwe regels. - Bewaar alle informatie

Houd bij welke stappen je hebt genomen om aan de regels voor transparantie te voldoen. Deze informatie kan nodig zijn als er controles gedaan worden of als toezichthouders vragen stellen.

Tijdlijn en deadlines van de AI Act

De EU heeft een tijdlijn opgesteld om de AI-verordening volledig door te voeren. Hieronder nogmaals een toelichting en schematische weergave (hieronder) van deze tijdlijn:

Fase 1 – 1 februari 2025

Verbod op het gebruik van AI-systemen met een onacceptabel risico. Verplichting tot AI-geletterdheid: medewerkers moeten voldoende vaardigheden, kennis en competenties hebben voor het gebruik van AI.

Fase 2 – 1 mei 2025

Deadline opstellen gedragscodes aanbieders General Purpose AI (GPAI)*.

Fase 3 – 1 aug 2025

Voldoen aan bepalingen uit categorie beperkt risico:

– GPAI-verplichtingen

– oprichten nationale toezichthouders

– publicatie richtlijnen voor toezicht en boetes

Fase 4 – 1 aug 2026

Voldoen aan bepalingen uit categorie hoog risico, met uitzondering van Large Scale IT-systems.

Fase 5 – 1 aug 2027

Large Scale IT-systems, zoals die voor grenscontroles, moeten ook voldoen aan de eisen van de categorie hoog risico.

* GPAI staat voor General Purpose AI. Dit zijn AI-systemen die je voor meerdere taken kunt inzetten, zonder dat ze vooraf specifiek voor één enkele toepassing zijn ontworpen. Een voorbeeld hiervan is GPT-3, het AI-model dat de basis vormt voor ChatGPT.

Tijdlijn AI Act

Meer informatie

- Meer over AI lees je in onze blog: ‘De invloed van AI (artificial intelligence) op de overheid’.

- Blog 1 uit deze serie AI Act: Wat betekent de nieuwe wetgeving voor Nederlandse overheidsorganisaties?

- Blog 2 uit deze serie: AI Act Fase 1: stappenplan voor onacceptabele risico’s

- Blog 3 uit deze serie: AI Act fase 2: General Purpose AI (GPAI)

- Website Digitale overheid

- Website EU Artificial Intelligence Act

- AI Act Explorer

- AI Act compliance checker

- Stel je vragen over de AI Act aan het ministerie van Binnenlandse Zaken en Koninkrijksrelaties (BZK): ai-verordening@minbzk.nl

Onze experts vertellen je hoe je met behulp van AI jouw werkprocessen kan versnellen. Neem contact met ons op of vraag een demo aan.