De Europese AI Act (AI-verordening) helpt ons om AI veilig, transparant en ethisch te ontwikkelen en gebruiken. Sinds 1 augustus 2024 is de wet van kracht, met een gefaseerde invoering. Nadat Fase 1 zich richtte op het verbieden van onacceptabele AI-risico’s, staat nu Fase 2 centraal. Deze fase zoomt in op General Purpose AI (GPAI) en het opstellen van gedragscodes hiervoor. Dit artikel legt uit wat GPAI is, welke verplichtingen de AI Act stelt en wat dit betekent voor organisaties.

De Europese AI Act (AI-verordening) is sinds 1 augustus 2024 van kracht en zet de koers uit voor veilige, transparante en ethische AI in Europa. Vanwege de complexiteit en de impact op organisaties wordt deze wet gefaseerd ingevoerd via een risicogebaseerde aanpak.

In ons vorige artikel, ‘AI Act Fase 1: stappenplan voor onacceptabele risico’s‘, hebben we de eerste cruciale fase belicht. Deze fase, met de deadline van 1 februari 2025, richt zich op het identificeren en uitfaseren van AI-systemen die een onacceptabel risico vormen voor burgers. Denk hierbij aan systemen voor subliminale manipulatie, social scoring of het exploiteren van kwetsbare groepen. Ook benadrukten we het belang van AI-geletterdheid binnen organisaties om aan deze eerste eisen te voldoen.

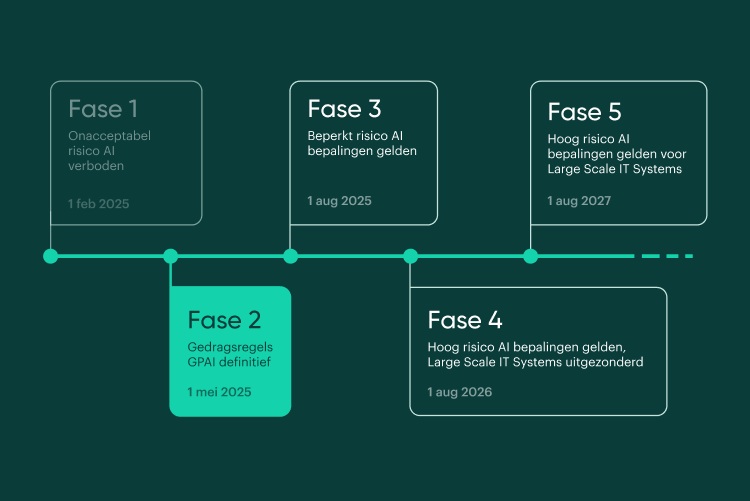

De tijdlijn van de AI Act

De AI Act wordt stap voor stap ingevoerd. Hieronder zie je wanneer welke fase in gaat:

Tijdlijn AI Act, deadline Fase 2 komt eraan.

Nu de eerste deadline in zicht komt, verschuift de focus naar de volgende deadline: Fase 2. Deze fase staat in het teken van General Purpose AI (GPAI).

In dit artikel duiken we dieper in op GPAI. We leggen uit wat het precies inhoudt en welke specifieke verplichtingen de AI Act oplegt aan aanbieders van deze systemen. Tot slot bespreken we wat de naderende deadline voor het opstellen van gedragscodes betekent voor zowel ontwikkelaars als gebruikers binnen (overheids)organisaties.

Wat is General Purpose AI (GPAI)?

General Purpose AI (GPAI) is een vorm van artificiële intelligentie (AI). In onze eerste blog uit deze serie vertellen we alles over AI en de invloed van AI op de overheid. Hierin benoemen we GPAI al kort. Simpel gezegd is GPAI, of ‘AI voor algemene doeleinden’, een type AI-systeem dat niet is ontworpen voor slechts één specifieke taak. In plaats daarvan kan het voor veel verschillende doelen gebruikt worden.

Denk aan systemen zoals ChatGPT of Google Gemini (die taal kunnen genereren, samenvatten, vertalen en meer) of beeldgeneratoren zoals DALL-E en Midjourney. Je kunt ze vragen een gedicht te schrijven, een complexe vraag te beantwoorden, code te schrijven of een afbeelding te creëren op basis van een beschrijving. GPAI-systemen hebben een zelflerend vermogen en kunnen vaak in verschillende domeinen of voor nieuwe taken worden ingezet, soms met wat extra training. Ze vormen vaak de kern waar specifiekere AI-toepassingen op worden gebouwd.

De motor achter GPAI: foundation models

Heel vaak ligt de sleutel bij zogenaamde foundation models (basismodellen). Dit zijn enorme AI-modellen die getraind zijn op gigantische hoeveelheden data. Vaak is deze data een mix van tekst, afbeeldingen en andere informatie van het internet.

Door deze intensieve training leren foundation models algemene patronen, structuren en een soort ‘basiskennis’ van de wereld zoals die in de data wordt gerepresenteerd. Voorbeelden zijn modellen zoals GPT-4 (de motor achter ChatGPT), Midjourney, of DALL-E (dat tekst en beeld koppelt).

Het cruciale kenmerk van foundation models is dat ze dienen als een fundament. Ze hoeven niet voor elke nieuwe taak vanaf nul getraind te worden. In plaats daarvan kunnen ontwikkelaars ze aanpassen met kleinere, taakspecifieke datasets. Dit maakt het mogelijk om snel krachtige, gespecialiseerde AI-toepassingen te bouwen bovenop een solide, algemene basis.

GPAI vs. foundation model: hoe zit het precies?

De termen GPAI en foundation model worden vaak in één adem genoemd, wat logisch is, maar ze betekenen net iets anders:

- Foundation Model

Verwijst naar de onderliggende technologie – het grote, vooraf getrainde basismodel zelf. Het is het resultaat van de grootschalige training. - GPAI

Beschrijft de functionaliteit van een AI-systeem – het vermogen om een breed scala aan taken uit te voeren. Deze functionaliteit wordt vaak mogelijk gemaakt door een foundation model.

Je kunt zeggen dat het foundation model de krachtige motor is, terwijl GPAI de veelzijdige auto is die door die motor wordt aangedreven.

Belangrijk detail: veel bekende foundation models zijn Large Language Models (LLM’s), zoals GPT-4, die gespecialiseerd zijn in taal. Echter, de term ‘foundation model’ is breder en omvat ook basismodellen getraind op beelden, code, of zelfs wetenschappelijke data. Een LLM is dus een type foundation model, maar niet alle foundation models zijn LLM’s.

Praktijkvoorbeelden van GPAI (en de risico’s)

GPAI-systemen worden nu al op diverse manieren ingezet, ook binnen de publieke sector. Hier zijn enkele voorbeelden en de bijbehorende risico’s:

- Taalmodellen (zoals GPT-3/4)

Toepassing: Automatisch samenvatten van rapporten, genereren van standaardbrieven, ondersteuning bij klantenservice (chatbots).

Risico’s: Kan onnauwkeurige of bevooroordeelde teksten produceren, of ongepaste antwoorden geven, wat leidt tot misinterpretaties of verkeerde besluiten. - Beeldgeneratie (zoals Midjourney)

Toepassing: Creëren van visueel materiaal voor voorlichtingscampagnes of educatieve doeleinden.

Risico’s: Kan misleidende, ongepaste of cultureel ongevoelige beelden genereren die publieke communicatie kunnen schaden. - Cloud-gebaseerde AI (zoals Microsoft Azure AI Studio)

Toepassing: Automatiseren van administratieve processen zoals belastingaangiften of subsidiebeheer.

Risico’s: Kwetsbaarheden in cloudsystemen kunnen leiden tot datalekken van gevoelige (persoons)gegevens. - AI-programmeertools (zoals GitHub Copilot)

Toepassing: Ondersteuning bij het ontwikkelen van digitale diensten en beheren van IT-infrastructuur.

Risico’s: Gegenereerde code kan fouten of veiligheidslekken bevatten, wat overheidsdiensten kwetsbaar maakt. - Vertaalmodellen (zoals Google Translate)

Toepassing: Toegankelijk maken van informatie en diensten voor anderstaligen via automatische vertalingen.

Risico’s: Vertalingen kunnen onnauwkeurig zijn of context missen, wat vooral problematisch is bij juridische of beleidsdocumenten.

De brede inzetbaarheid van GPAI maakt het lastig om alle mogelijke uitkomsten en risico’s vooraf te overzien. Eén fout in een veelgebruikt basismodel kan onbedoelde gevolgen hebben in talloze toepassingen. Daarom stelt de AI Act specifieke eisen.

Verplichtingen voor GPAI onder de AI Act

De AI Act legt de verantwoordelijkheid voor GPAI grotendeels bij de aanbieders van de foundation models. Zij moeten voldoen aan een aantal eisen om de veiligheid en betrouwbaarheid te waarborgen:

- Risicobeoordeling

Potentiële risico’s (technisch, ethisch, maatschappelijk) moeten worden geïdentificeerd en geanalyseerd. - Data governance

Er moeten processen zijn voor verantwoord databeheer, inclusief controle op kwaliteit, privacy en het voorkomen van vooroordelen (bias) in datasets. - Prestaties en beveiliging

De modellen moeten betrouwbaar functioneren en robuust zijn tegen storingen of cyberaanvallen. - Duurzaamheid

De milieu-impact (met name energieverbruik) moet worden geëvalueerd en waar mogelijk beperkt. - Technische documentatie

Gedetailleerde documentatie moet beschikbaar zijn voor toezichthouders en gebruikers van het model. - Kwaliteitsmanagement

Er moeten systemen zijn voor continue monitoring, testen en verbetering van het model.

Extra eisen voor generatieve AI: Foundation models die worden gebruikt voor generatieve AI (zoals het maken van tekst, beeld of code) moeten aan aanvullende regels voldoen:

- Transparantie over trainingsdata

Er moet een samenvatting worden gepubliceerd van de data die is gebruikt voor de training, met name aandacht voor auteursrechtelijk beschermd materiaal. (Let op: dit betekent niet automatisch dat het gebruik van die data legaal is). - Aanduiding van AI-gegenereerde content

Output die bedoeld is om op echte personen, objecten, etc. te lijken (deepfakes) moet duidelijk als kunstmatig gemarkeerd worden, tenzij dit technisch onmogelijk is of voor legitieme doeleinden (kunst, satire) gebeurt met behoud van fundamentele rechten.

Fase 2: gedragscodes voor GPAI opstellen

Een belangrijk onderdeel van Fase 2, met de deadline van 1 mei 2025, is het opstellen van vrijwillige gedragscodes (Codes of Conduct) voor GPAI. Deze codes moeten organisaties helpen om de wettelijke verplichtingen uit de AI Act in de praktijk te brengen. Ze zullen zich richten op aspecten als transparantie, veiligheid, privacy en de impact op fundamentele rechten.

De ontwikkeling van deze gedragscodes is een samenwerking:

- Aanbieders van GPAI-modellen

Nemen het initiatief en werken samen om praktische richtlijnen op te stellen die aansluiten bij de stand van de techniek. - Europese Commissie (AI Office)

Faciliteert en moedigt de ontwikkeling aan, en beoordeelt uiteindelijk of de codes voldoen aan de doelstellingen van de AI Act. - Belanghebbenden

Andere partijen, zoals gebruikersorganisaties, overheden en experts, kunnen input leveren.

Hoewel de codes vrijwillig zijn, wordt verwacht dat ze een belangrijke standaard zullen worden in de sector.

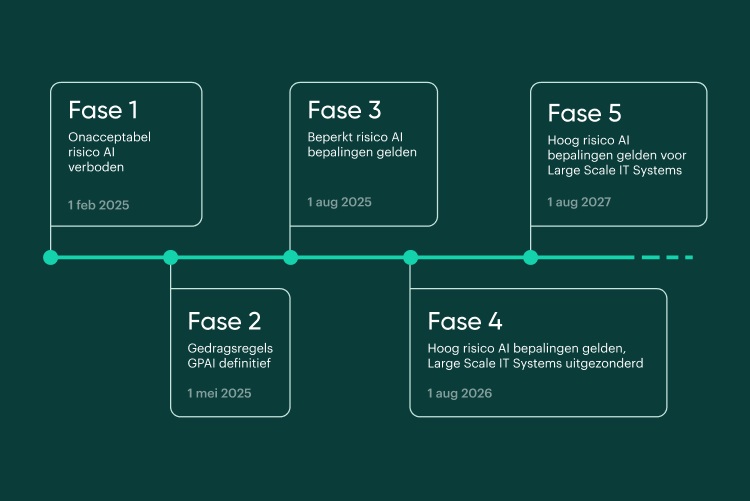

Tijdlijn en deadlines van de AI Act

We lieten je eerder al de tijdlijn zien die de EU heeft opgesteld om de AI-verordening volledig door te voeren. Nogmaals een toelichting en schematische weergave (hieronder) van deze tijdlijn:

Fase 1 – 1 februari 2025

Verbod op het gebruik van AI-systemen met een onacceptabel risico. Verplichting tot AI-geletterdheid: medewerkers moeten voldoende vaardigheden, kennis en competenties hebben voor het gebruik van AI.

Fase 2 – 1 mei 2025

Deadline opstellen gedragscodes aanbieders General Purpose AI (GPAI).

Fase 3 – 1 aug 2025

Voldoen aan bepalingen uit categorie beperkt risico:

- GPAI-verplichtingen

- Oprichten nationale toezichthouders

- Publicatie richtlijnen voor toezicht en boetes

Fase 4 – 1 aug 2026

Voldoen aan bepalingen uit categorie hoog risico, met uitzondering van Large Scale IT-systems.

Fase 5 – 1 aug 2027

Large Scale IT-systems, zoals die voor grenscontroles, moeten ook voldoen aan de eisen van de categorie hoog risico.

Tijdlijn AI Act.

De volgende belangrijke deadline is 1 augustus 2025. Dan gelden de bepalingen voor AI met beperkt risico, dit is fase 3 van de AI Act. Wij blijven de ontwikkelingen rondom deze AI Act volgen, en houden je via onze blog op de hoogte over de laatste updates.

Meer informatie

Meer weten over de impact van AI op jouw organisatie?

Benieuwd hoe AI jouw documentverwerking kan verbeteren? Of hoe wij deze technologieën in onze software integreren? Neem contact met ons op.