Gevoelige gegevens verwerken om discriminatie door AI tegen te gaan?

Mag een organisatie testen of haar AI-systeem sollicitanten met een bepaalde etniciteit onterecht discrimineert? In ieder geval stuit je op een probleem: de organisatie kent de etniciteit van haar sollicitanten vaak niet. In beginsel verbiedt de AVG het gebruik van bepaalde categorieën gevoelige persoonsgegevens, waaronder etniciteit. Moet er een uitzondering worden opgenomen in de wet? Frederik Zuiderveen Borgesius en Marvin van Bekkum van de Radboud Universiteit Nijmegen onderzochten het vraagstuk.

- Belemmeren de regels van de AVG over bijzondere persoonsgegevens het tegengaan van discriminerende effecten van AI-systemen?

- Wat zijn de argumenten voor en tegen het creëren van een nieuwe uitzondering op het AVG-verbod op het gebruik van bijzondere persoonsgegevens om discriminatie door AI-systemen tegen te gaan?

Een uitzondering op het AVG-verbod op het gebruik van bijzondere persoonsgegevens zou kunnen worden opgenomen in de AVG, of in een andere wet, nationaal of op EU-niveau. Wij richten ons alleen op discriminatie met betrekking tot bepaalde beschermde gronden in de non-discriminatierichtlijnen van de EU, namelijk etniciteit, godsdienst of overtuiging, handicap en seksuele geaardheid. In Nederland zijn die richtlijnen grotendeels geïmplementeerd in de Algemene wet gelijke behandeling (Awgb).

1. Belemmerende regels van de AVG

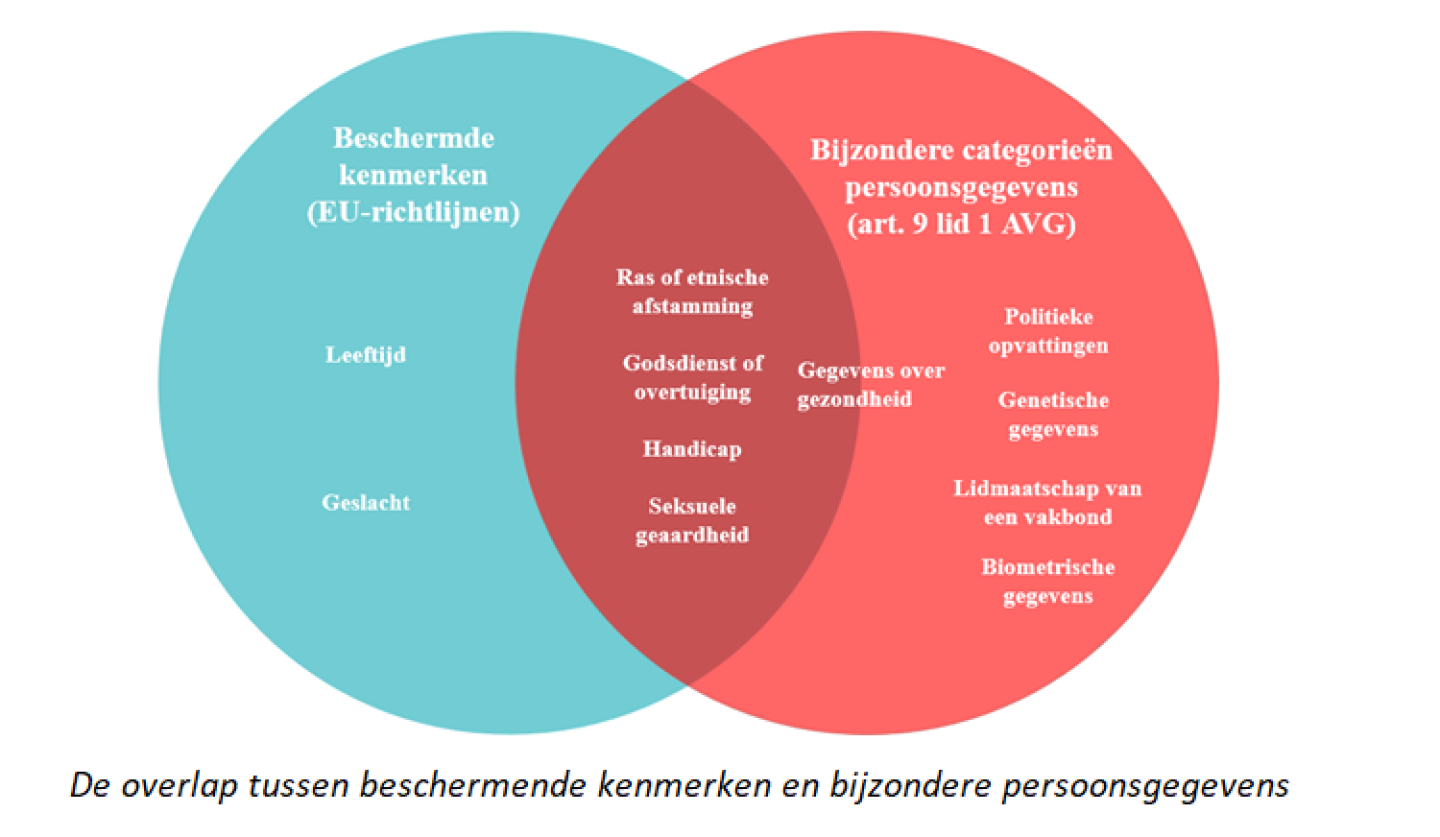

De AVG verbiedt in veel gevallen de verwerking van bijzondere persoonsgegevens, ook als het gaat om het tegengaan van discriminerende effecten van AI-systemen. Artikel 9 lid 1 AVG bevat een verbod (met uitzonderingen) op het gebruik van bepaalde soorten extra gevoelige gegevens, de zogenaamde ‘bijzondere categorieën van persoonsgegevens’. Deze categorieën overlappen grotendeels met de beschermde kenmerken uit de non-discriminatierichtlijnen van de Europese Unie. Overigens verbiedt de Nederlandse Algemene Wet Gelijke Behandeling ook discriminatie op grond van ‘politieke gezindheid’.

Er bestaan uitzonderingen voor het verbod van Artikel 9 AVG, maar die uitzonderingen zijn over het algemeen niet geschikt zijn voor het controleren van AI-systemen. In sommige gevallen kan een organisatie toestemming van mensen krijgen om de data te verzamelen. In andere situaties zou een EU- of nationale wet nodig zijn om het gebruik van bijzondere gegevenscategorieën voor AI-debiasing mogelijk te maken – op dit moment zijn dergelijke wetten niet van kracht in de EU. Daarom zijn organisaties momenteel aangewezen op de toestemmingsuitzondering.

Maar in veel gevallen is het verkrijgen van geldige toestemming onmogelijk. Stel bijvoorbeeld dat een organisatie sollicitanten vraagt of ze toestemming geven voor het gebruik van hun etnische gegevens om discriminerende effecten door haar AI-systemen tegen te gaan. De AVG vereist dat een dergelijke toestemming vrijwillig wordt gegeven. Werkzoekenden kunnen echter het gevoel hebben dat ze verplicht zijn om toestemming te geven om de baan te krijgen waarvoor zij solliciteren. Dat neemt de vrijwilligheid van de toestemming weg.

2. Argumenten voor en tegen het creëren van een nieuwe uitzondering

We konden het niet eens worden of het aannemen van zo’n uitzondering een goed idee zou zijn. Allebei zijn we vaak van mening veranderd. Hieronder noemen we de belangrijkste voor- en tegenargumenten.

Er is één belangrijk argument voor het aannemen van een uitzondering. Organisaties kunnen de bijzondere persoonsgegevens gebruiken om discriminatie door AI tegen te gaan.

De vier belangrijkste argumenten tegen een uitzondering zijn als volgt.

- Alleen al het opslaan van gevoelige persoonsgegevens bedreigt onze privacy. Het voelt ongemakkelijk als organisaties informatie verzamelen over onze etniciteit, religie of seksuele voorkeuren.

- Het opslaan van gegevens brengt altijd risico's met zich mee, vooral als het gaat om gevoelige gegevens. De gegevens kunnen bijvoorbeeld voor onverwachte doelen worden gebruikt, onbevoegden kunnen de gegevens bekijken, of er kan een datalek optreden.

- Organisaties zouden misbruik kunnen maken van zo’n uitzondering. Sommige organisaties zouden veel gevoelige gegevens kunnen verzamelen, en claimen dat ze dat alleen doen om AI-discriminatie tegen te gaan.

- Het ontwikkelen van niet-discriminerende AI staat in technische zin nog in de kinderschoenen. Zelfs als het gebruik van persoonsgegevens over bijvoorbeeld etniciteit noodzakelijk is om niet-discriminerende AI-systeem te ontwikkelen, betekent dat nog niet dat niet-discriminerende AI ontwikkelen ook altijd mogelijk is.

Het is afwachten hoe de uiteindelijke tekst van de AI Act van de Europese Unie er komt uit te zien.

Als er een wettelijke uitzondering zou worden aangenomen, dan zouden er ook waarborgen moeten zijn. Een optie zou bijvoorbeeld een regulatory sandbox kunnen zijn waar autoriteiten toezicht houden op de juiste opslag en het juiste gebruik van de gegevens. Of wellicht kan het CBS de gegevens geanonimiseerd aan organisaties verstrekken, zoals bij de barometer culturele diversiteit.

De EU onderhandelt nu over de tekst van een een ‘AI Act’, met regels voor AI. Het is afwachten hoe de uiteindelijke tekst van de AI Act van de Europese Unie er komt uit te zien. Waarschijnlijk zal die AI Act een uitzondering bevatten op de AVG, om het gebruik van bijzondere gegevens mogelijk te maken voor het tegengaan van AI-discriminatie. Het is te hopen dat de AI Act genoeg waarborgen zal bevatten om de risico’s van zo'n uitzondering tegen te gaan.

Dit artikel is gebaseerd op een artikel van de auteurs in het Nederlands Juristenblad.

Plaats een reactie

U moet ingelogd zijn om een reactie te kunnen plaatsen.

Mooie discussie, maar zonde om dit vraagstuk alleen vanuit het Recht te beoordelen. De gestelde patstelling is prima te doorbreken met moderne middelen, maar vereist een multidisciplinaire aanpak. Je hebt IT-deskundigen nodig om een toestemmingsmodule te bedenken, bouwen en te integreren in het sollicitatiesysteem en onder de juiste technische beveiligingsmaatregelen te implementeren. Gegevenswetenschaps- en AI-teams kunnen de kennis leveren voor de AI-audit en bias-monitoring tools om te waarborgen dat AI-systemen correct en ethisch gebruik maken van deze gegevens. HR- en juridische teams formuleren toestemmingsverklaring en privacybeleidom ervoor te zorgen dat het proces voldoet aan alle relevante wet- en regelgeving. Compliance- en auditspecialisten beheren de compliance- en auditmechanismen, monitoren de naleving en voeren (realtime?) controles uit. Er kunnen nog veel meer wetten, regels en compliance reguleringen van belang zijn, dan alleen de AVG, zoals de Wet gelijke behandeling op grond van leeftijd bij arbeid (WGBL) die discriminatie verbiedt op grond van leeftijd in werk gerelateerde situaties, en vereist dat organisaties maatregelen nemen om deze vorm van discriminatie te voorkomen.

De Arbeidsomstandighedenwet (Arbo) die vereist dat werkgevers een beleid voeren dat gericht is op het voorkomen of beperken van psychosociaal arbeidsbelasting, wat discriminatie kan omvatten.

Dan zijn er nog sectorale codes en richtlijnen die van toepassing kunnen zijn, maar het kan prima:

Er zijn verschillende technieken om privacygevoelige gegevens te gebruiken terwijl AVG wordt gerespecteerd. Een daarvan is Zero-Knowledge Proof (ZKP), een cryptografisch protocol waarbij een partij (de prover) aan een andere partij (de verifier) kan bewijzen dat ze een bepaalde informatie kent of bezit, zonder die informatie daadwerkelijk te onthullen.

In een sollicitatieprocedure kan dit bijvoorbeeld zo werken: een allochtone kandidaat moet zijn/haar etniciteit invullen, wat gevoelige informatie is. Met Zero-Knowledge Proof kan de kandidaat bewijzen dat hij/zij deze informatie heeft ingevuld, zonder dat de informatie zelf wordt onthuld.

De Fiware Context Broker (www.fiware.org/catalogue) kan hierbij helpen door de context van deze informatie te beheren. Het maakt gebruik van NGSI-LD (Next Generation Service Interface-Linked Data) als standaard voor het structureren van contextinformatie.

Laten we aannemen dat we een entiteit 'Applicant' hebben met de attributen 'ApplicantId' (een unieke identifier) en 'hasProvidedEthnicity' (een attribuut dat aangeeft of de aanvrager zijn/haar etniciteit heeft opgegeven).

Een triple kan er als volgt uitzien:

"123".

"true".

In NGSI-LD kan de entiteit er als volgt uitzien:

{

"id": "urn:ngsi-ld:Applicant:123",

"type": "Applicant",

"ApplicantId": {

"type": "Property",

"value": "123"

},

"hasProvidedEthnicity": {

"type": "Property",

"value": true

}

}

In dit scenario is de daadwerkelijke etnische informatie van de sollicitant niet opgenomen in de Context Broker, respecterend de privacy van de sollicitant. Met Zero-Knowledge Proof kan de organisatie echter bevestigen dat de sollicitant deze informatie heeft verstrekt, zonder de informatie zelf te onthullen.